MPEG-H in Texas auf der SXSW2018

Vom 09. bis zum 14. März 2018 fand DAS Festival der Kultur- und Kreativwirtschaft schlechthin statt: das „South by Southwest“ (SXSW) in Austin/Texas. Das Fraunhofer IDMT, bekannt als Entwicklerin des mp3-Formates, präsentierte dort gemeinsam mit Aspekteins und den MediaApes neben verschiedenen VR- und AR-Welten ihre neue 3D-Audiotechnologie SpatialSoundWave. Mit diesem objektbasierten Produktions- und Wiedergabesystem wird auf Anwenderseite nicht nur eine dreidimensionale richtungsgerechte Beschallung möglich, sondern auch Produzenten wird ein Werkzeug an die Hand gegeben, mit dessen Hilfe sie dank intuitiver Bedienung ganz einfach räumliche Audioinhalte erzeugen können.

- Gemeinschaftsstand Fraunhofer IDMT, MediaApes GmbH & Aspekteins GmbH SXSW2018

- Headphone Audio Demo am Gemeinschaftsstand

- Wellenfeldsynthese Array in Kombination mir VR Headset, Technologie des Fraunhofer IDMT im Zusammenspiel mit Audio Inhalten der Media Apes GmbH und Visuals der Aspekteins GmbH

- Wegweiser zum Stand und in die Zukunft

Um jedoch die Entwicklung sowie die Grundlagen dieses neuen Soundkonzeptes verstehen zu können, müssen wir eine kleine Zeitreise ins Jahr 2014 unternehmen und Zeuge werden, wie das Fraunhofer ISS seinen neuen MPEG-H 3 D Audio-Standard vorstellt und ihn in den folgenden Jahren auf zahlreichen Messen wie zum Beispiel der IBC 2015 oder der CES 2017 in Las Vegas präsentiert.

Doch was unterscheidet dieses Next Gen Audio-Format von anderen 3 D-Audioformaten? Und welche Rolle spielt es im Bereich der Virtual-Reality?

Immersive Sounderlebnisse schaffen mit interaktivem Sounderlebnis

Für die Produktion immersiver Töne und deren Wiedergabe gibt es mehrere Technologien, die sich grob in drei Kategorien einteilen lassen: Kanal-basiert, Objekt-basiert und Schallfeld-basiert. Im Vergleich zu anderen Audioformaten geht es bei MPEG-H nicht nur um die reine Klangwiedergabe, sondern um ein interaktiv nutzbares System, das Klänge so codiert, dass sie vom Anwender individuell auf ihre jeweiligen Bedürfnisse eingestellt beziehungsweise sogar verändert werden können. Als konkretes Anwendungsbeispiel nennt Stefan Meltzer, der am Fraunhofer IIS für die Markteinführung von MPEG-H zuständig war, die individuell regulierbare Lautstärke einzelner Soundkomponenten. Möglich gemacht wird das dadurch, dass bei der objektbasierten Tonproduktion alle Klanginformationen einzeln produziert oder aufgenommen und erst bei der Wiedergabe zusammengefügt werden. Möchte man bei einer Fußballübertragung also nur die Lautstärke der Kommentatorenstimme erhöhen, nicht aber die Hintergrundgeräusche des Stadions, so lässt sich dies mit dem MPEG-H-Verfahren problemlos realisieren. Was zunächst danach klingen mag, aufwendig in der Produktion und teuer im Erwerb zu sein, wurde Ende Mai 2017 in Seoul/Südkorea bereits standardisiert in Betrieb genommen, bis ins Jahr 2020 soll das UHD-TV (Ultra High Definition TV) dann auch im ganzen Land empfangen werden können. Auch die britische BBC hat 2016 im Rahmen des europäischen Forschungsprojektes ORPHEUS bereits ein Probe-Studio mit der nötigen Technik für die Verarbeitung objektbasierter Audio-Daten eingerichtet.

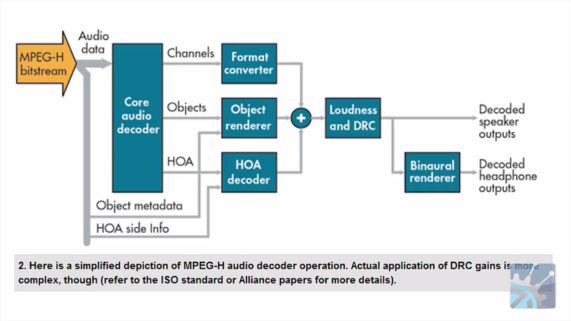

Auf den Punkt gebracht: Mit MPEG-H liegt ein Format vor, das nicht mehr länger an eine festgelegte Anzahl von Ausgabekanälen, die auf bestimmte Art und Weise im Raum angeordnet sein müssen, gebunden ist, sondern stattdessen mit einem 3 D mapping des Raumes arbeitet, bei dem Schallereignisse in virtuelle Audio-Objekte verwandelt und mithilfe von Metadaten organisiert werden. Diese Metadaten liefern unter anderem Informationen über Position und Lautstärke der Schallquelle und werden bei der Wiedergabe von einem Renderer als Berechnungsgrundlage der Lautsprechersignale herangezogen. Dass die Metadaten dabei dynamisch veränderbar sind, bringt nicht nur dem Anwender Vorteile, sondern auch Produzenten immersiver Sounderlebnisse können so beispielsweise sich bewegende Schallquellen und damit eine realistische Klangkulisse simulieren.

It’s all about that bass…

Dass das Klangerlebnis, das mit MPEG-H Audio erzeugt werden kann, weit über herkömmlichen Surround Sound hinaus geht, lässt sich anhand dieses Artikels zwar erahnen – letzen Endes jedoch sollte es erlebt werden um es tatsächlich in allen Dimensionen erfassen zu können. Welche Rolle das Format nun nun bei der Produktion von VR-Inhalten spielt, hängt davon ab, welche Art von Anwendung man entwickeln möchte, da unterschiedliche Arten von virtueller Realität auch unterschiedliche Anforderungen an die Auralisation stellen.

Da so genannte lineare VR-Anwendungen es sich zum Beispiel nicht zum Ziel gesetzt haben, dem Nutzer das Gefühl zu geben, sich tatsächlich in der künstlich geschaffenen Welt zu befinden, sie also nicht auf Immersion und Interaktion ausgelegt sind, müssen die für die Anwendung verwendeten akustischen Signale zwar so aufgenommen werden, dass sie konsistent mit der Perspektive des Nutzers übereinstimmen und es nicht zu Verzögerungen zwischen Bild und Ton kommt, der Klang muss allerdings nicht zur Gänze umhüllend sein, kann es jedoch auch. Setzt man bei der Produktion linearer VR-Anwendungen wie zum Beispiel 360 Grad Videos oder Übertragungen von Sport- oder Musikevents das MPEG-H-Format ein, schafft man für den Nutzer, der bei dieser Art der Virtual-Reality normalerweise so gut wie keinen Einfluss ausüben kann, die Möglichkeit einer nicht nur interaktiven, sondern individuellen Veränderung,wenn man ihn beispielsweise die Stimme des Kommentators unabhängig von den Hintergrundgeräuschen lauter stellen lässt. Das verringert grundsätzlich zwar weder die Qualität noch die Faszination der Anwendung, beraubt sie jedoch trotz Interaktivität ihrer realistischen und damit immersiven Komponente. Ein gesteigerter Grad an Immersion lässt sich mithilfe des Einsatzes von MPEG-H also vor allem bei interaktiven VR-Anwendungen erreichen, bei denen der Nutzer den vorproduzierten objektbasierten Sound, der sich mit ihm durch den virtuellen Raum bewegt, nicht verändert, sondern ihn in seiner Realistik auf sich einwirken lässt. Doch MPEG-H eignet sich nicht nur zur Erzeugung und Wiedergabe von perfektem Rundumklang, sondern kann auch dabei helfen, den Nutzer durch die Anwendung zu führen und seine Aufmerksamkeit zu lenken, wobei man vom so genannten auditivem handrailing spricht.

Wenn Sie neugierig geworden sind und gerne mehr über die State of the Art-Konzeption und Produktion von 3 D-Audio im Rahmen von Virtual- und Augmented-Reality Anwendungen erfahren möchten, wenden Sie sich gerne an die Experten der Aspekteins GmbH, wir freuen uns von Ihnen zu hören.

HIER KLICKEN FÜR IHR 360° / VR-PROJEKT

Bildrechte Galerie: © Benjamin Klose für Media Apes GmbH