:quality(80)/business-review.eu/wp-content/uploads/2017/04/vr.jpg)

Bildquelle: media.business-review.eu

Grundsätzlich stellen VR-Headsets virtuelle Welten dar, indem sie, gemäß dem stereoskopischen Sehvorgang, in Echtzeit Umgebungen aus zwei leicht zueinander verschobenen Kamerapositionen berechnen. In einem Bruchteil einer Sekunde wird das Bild auf Basis der aktuellen Position des Headsets im Raum neu berechnet und auf den Linsen wiedergegeben. Die Latenz, also die Zeit zwischen dem Start der Berechnung und der Wiedergabe im Headset, ist so gering, dass sie für den Menschen nicht mehr wahrnehmbar ist.

Doch die Linsen, auf denen die berechneten Bilder wiedergegeben werden, sind mit der Projektion ihrer Inhalte und entsprechender Lichtquellen immer nur wenige Zentimeter von unserem Auge entfernt. Wie also können unter diesen Umständen klare Bilder erzeugt werden, die zur perfekten Illusion der dargestellten Welten werden? Und welchen Einfluss hat dieser Vorgang auf unsere Augen?

Was ist Akkommodation?

Accommodare heißt im Lateinischen „anpassen“ und bezeichnet die Fähigkeit des Auges, den Brennpunkt durch die optische Brechkraft des Auges zu beeinflussen. Die Schärfeebene – also der Bereich, den wir scharf sehen – kann also aktiv an die Entfernung eines Gegenstandes angepasst werden.

Vorgang der Akkommodation beim Auge. Bildquelle: brille24.de

Unsere Augen sind dank eines ringförmigen Muskels höchst elastisch und können von einem Moment zum anderen sowohl flach (Fernsicht) als auch gewölbt (Nah-Akkommodation) sein. Im entspannten Zustand liegt dieser Muskel weiter außen im Auge, im entgegengesetzten Fall bewegt er sich zur Augenlinse hin. In der Konsequenz wird das durch die Linse einfallende Licht auch unterschiedlich stark gebrochen.

Bei der Nah-Akkommodation vollziehen beide Augen eine sog. Konvergenz („zusammenführen“). Dabei wenden sich die Augäpfel nach innen, um einen Gegenstand im Nahbereich scharf stellen zu können. Die komplexe Muskulatur des Auges lässt hier eine rollende Bewegung zu, durch die sich die gedachte horizontale Achse der Augäpfel früher schneidet, als dies bei fern liegenden Gegenständen der Fall ist. Man kann also sagen, die Sehachsen werden zusammengeführt, damit der in der Nähe liegende Gegenstand bestens fokussiert werden kann.

Im Visier virtueller Linsen

Bildquelle: howtogeek.com

Die Linse des VR-Displays, quasi der Ersatz unserer eigenen Augenlinse, muss also zunächst die (künstlich) einfallenden Lichtstrahlen so brechen, dass die Augen des Nutzers noch die Fähigkeit haben, auf der Netzhaut genügend scharfe Bilder wahrzunehmen.

Allerdings übernehmen die Linsen des Headsets durch ihre Krümmung auch die „Arbeit“ der eigenen Augenlinse und jegliche Inhalte haben vor unserem Auge erstmal auch den gleichen Abstand. Im Ergebnis bedeutet das: Nutzer können nicht mehr wie gewohnt den Vorder- oder den Hintergrund mit ihrem eigenen Auge fokussieren.

In diesem Fall spricht man auch von einer längeren Entkopplung beim sog. Akkommodation-Konvergenz-Vorgang.

Bildquelle: heise.de

Es gibt durchaus Ansätze, dieses Problem zu beheben:

Neben dem Raumvolumen sollen in der Entwicklung vermehrt auch natürliche Lichtverhältnisse bzw. Lichtreflexionen Berücksichtigung finden und virtuelle Objekte bei natürlicher Akkommodationsreichweite generiert werden.

giphy.com

Das Stichwort hier ist „Lichtfeld-Technologie“. Lichtfeld-Displays erzeugen einzelne Lichtstrahlen, die gezielt auf das Auge projiziert werden können. Somit können Nutzer ganz wie gewohnt einzelne Objekte im virtuellen Raum fokussieren.

Auf der CES 2019 hat Lemnis Technologies einige Prototypen mit dieser Art Display vorgestellt. Oculus verfolgt mit seinem Half-Dome-Prototypen einen anderen Ansatz: Verbaut ist hier ein Multifokus-Display, d.h. mehrere hintereinander angeordnete LCD-Linsen.

Sicht-Check

Doch was zeichnet die VR-Brillen aus, die heute schon auf dem Markt sind?

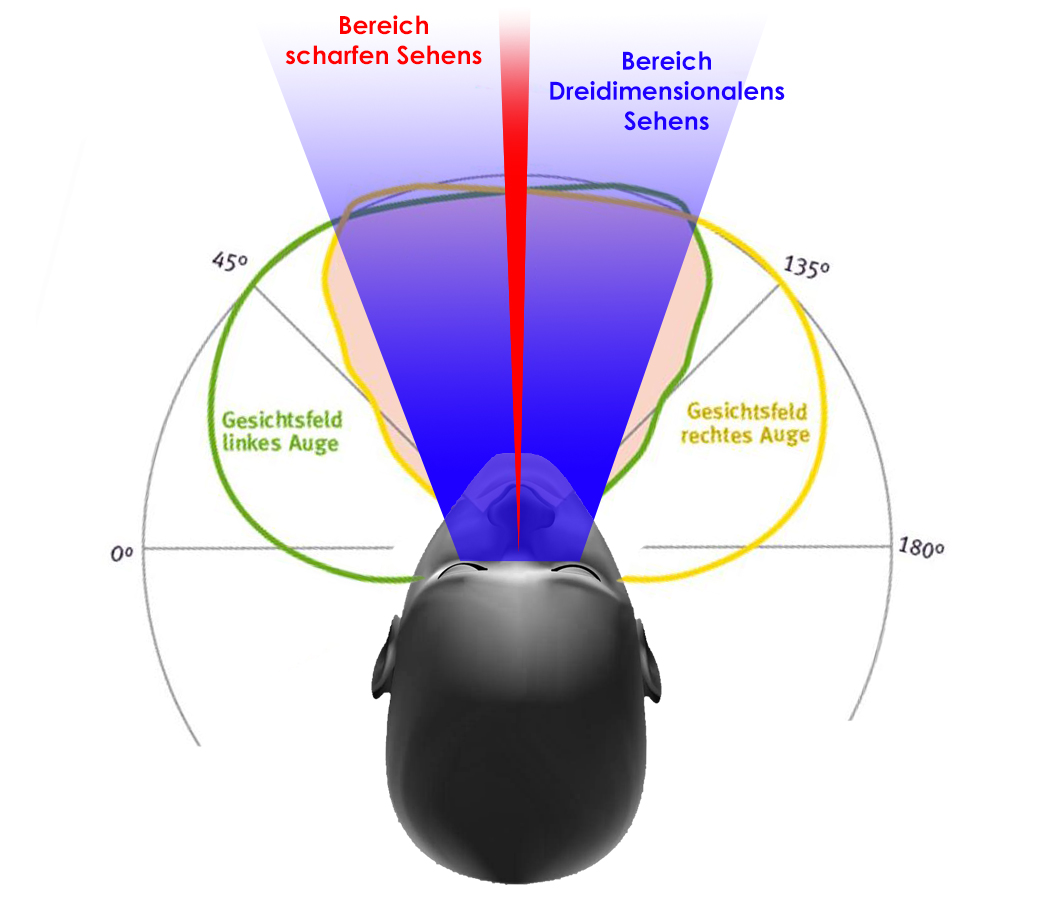

Die Qualität einer VR-Brille hängt nicht nur mit der Bildrate (die Rate, wie oft innerhalb einer Sekunde ein neues Bild auf den Displays erscheint) und der Auflösung des Displays zusammen, sondern ist auch eng mit dem Sichtfeld verknüpft. Das Sichtfeld (auch Field of View oder kurz FOV) umschreibt denjenigen Bereich, den das Headset abbilden kann. Im Falle der menschlichen Wahrnehmung wird dieser Bereich als derjenige definiert, innerhalb dessen noch Bewegungen, ungeachtet der Schärfentiefe, wahrgenommen werden können.

Bildquelle: fotokurs-bremen.de

Beim Menschen beträgt dieses horizontale Sichtfeld etwa 180 Grad, das vertikale Sichtfeld liegt bei 130 Grad (60 bzw. 70 Grad nach oben und unten). Insofern sind VR-Headsets mit einem großen FOV auch eher Garanten für ein immersives VR-Erlebnis, da ein zu enges Sichtfeld für einen Tunnelblick sorgt.

Auflösung, Bildrate und FOV sollten sich in ihrem Zusammenspiel also insgesamt einem natürlichen Sehvorgang annähern.

Je besser das Headset, umso immersiver die VR-Erfahrung!

Die meisten Headsets erlauben es, den Augenabstand im Verhältnis zum Display-Panel anzupassen. Dazu haben einige Headsets inzwischen sogar IPD-Apps für eine noch genauere Konfiguration, als eine rein manuelle Einstellung am Headset. Der richtige Abstand verhindert, dass virtuelle Objekte etwa perspektivisch kleiner oder größer erscheinen, als wir es gewohnt sind. Dies kann das immersive Empfinden des Trägers nachhaltig stören.

Bei Fehlsichtigkeit und Sehstörungen können auch teilweise Brillen unter dem Headset getragen werden; am besten sind aber Kontaktlinsen. Es gibt für die meisten VR-Brillen optional auch individuelle Ersatzlinsen zu kaufen.

Eine Frage des Headsets…

Samsung Gear Headset. Bildquelle: vrfilmpro.com

Grundsätzlich unterscheiden sich autarke, nicht-autarke und mobile VR-Headsets. Davon abhängig sind auch die sensorischen Gegebenheiten und Tracking-Optionen: Je nach Hardware ergeben sich hier unterschiedliche Rechen- bzw. Wiedergabeleistungen.

Nicht-autarke Headsets sind entweder über einen USB-Anschluss und/oder ein HDMI-Kabel an einen Computer (oder – im Falle der Playstation-VR-Brille – an eine Playstation 4) gebunden und benötigen leistungsstarke Hardware. Ausgestattet muss dieser mit einem entsprechenden Prozessor und einer Grafikkarte sein, die sich mindestens im oberen Mittelfeld aktueller Hardware bewegen sollte.

In autarken Headsets ist die benötigte Hardware direkt in der VR-Brille verbaut. Ein mobiler Prozessor sorgt hier für die Berechnung der virtuellen Welt. Im Vergleich zu nicht-autarken Headsets ist die Leistung jedoch – aufgrund des kleinen Formfaktors und der erschwinglichen Preisklasse – stark eingeschränkt.

Die Oculus Quest ist nicht nur ein autarkes Standalone-Headset, sondern inzwischen auch flexibel tethered, also nicht-autark an einem Computer, zu verwenden (Oculus Link). Damit können User je nach Situation auf die Rechenpower des Headsets selbst oder – für anspruchsvollere Anwendungen – auf die eines angeschlossenen Computers zurückgreifen.

Schließlich gibt es noch mobile Headsets auf Smartphone-Basis. Smartphone & Google Cardboard sind hier quasi die kostengünstigste Möglichkeit in VR einzusteigen. Die Berechnungen virtueller Darstellungen sind allerdings sehr stark limitiert und ermöglichen so kein komplexes Interagieren mit den Inhalten einer VR-Anwendung. Diese Variante ermöglicht nur ein sehr schwach immersives Erlebnis und gilt spätestens seit dem Erscheinen der Oculus Quest für anspruchsvollere VR-Anwendungen als nicht mehr relevant.

Funktionsweise einer Cardboard-Box. Bildquelle: mrcardboard.eu

Tracking & Sensorik

Das Tracking sorgt dafür, dass sich der virtuelle Avatar und damit die simulierte Kamera und die virtuellen Controller mit den Kopf-, Hand- und/oder Körperbewegungen des Users synchron bewegen.

Unterschieden wird hier unter anderem, wie viele Freiheitsgrade das Headset erfassen kann. Headsets mit drei Freiheitsgraden (3DoF) erfassen nur Rotationsbewegungen des Kopfes entlang der Achsen, Headsets mit sechs Freiheitsgraden (6DoF) erfassen zusätzlich zu Rotations- auch Translationsbewegungen: macht der User einen Schritt nach vorn, erkennt die Hardware entsprechend, dass sich das Headset auf der x-Achse bewegt hat.

Mit 6DoF kann also verfolgt werden, ob sich der User im Raum bewegt: nach vorne, hinten, seitlich oder vertikal und sogar nach oben oder unten. Dieser Umstand ermöglicht ihm, im Gegensatz zu 3DoF, absolute Beweglichkeit im virtuellen Raum – soweit es die physikalischen Grenzen des Zimmers zulassen.

6DoF-Tracking kann entweder durch externe Sensoren (Outside-In-Tracking) oder durch Sensoren, die direkt in der Kamera verbaut sind (Inside-Out-Tracking) betrieben werden. Während Outside-In-Tracking als zuverlässiger gilt (diese Unterschiede treten jedoch nur in Extremsituationen zum Vorschein), ist das Setup mit Inside-Out-Tracking deutlich komfortabler. Die ersten Headsets setzen zudem bereits zusätzlich auf Eyetracking.

Beim Eye-Tracking werden neben der Blickrichtung auch die Augenbewegungen gemessen. Bei HTCs Vive Eye Pro arbeiten hierfür mehrere um die Linsen verbaute LED-Sensoren.

Es gibt zahlreiche Potentiale dieser Technologie: Seien es virtuelle Charaktere, die Blickkontakt aufnehmen können oder Menüs, die sich alleine durch den Blick steuern lassen. Doch das vielleicht größte Potential hängt abermals mit der Auflösung des Headsets zusammen: Foveated Rendering (von „Fovea centralis“) wird genutzt, um Rechenleistung einzusparen. Angelehnt an den natürlichen Mechanismus des Auges wird nur derjenige Bereich scharf wiedergegeben, den der Nutzer gerade ansieht. Das ist entsprechend der Bereich, auf den die Sehgrube ausgerichtet ist. Im peripheren Bereich – also dem Areal, welches sich nicht im Fokus befindet – arbeitet das Headset mit niedriger Auflösung, während der Bereich der höchsten Bildqualität immer dort gegeben ist, wohin der Betrachter/User seinen Blick richtet.

Auswirkung des Foveated Rendering auf das generierte VR-Bild. Bildquelle: zerolightcom

Da wir auch beim natürlichen Sehvorgang nur den Bereich scharf sehen, den wir gerade betrachten, fällt diese Technik – subtil eingesetzt – Nutzern kaum auf. Es können aber deutliche Performancesteigerungen erzielt werden.

Welche VR-Erfahrung möchten Sie machen? Wir beraten Sie gerne und sind Ihr Partner für die Umsetzung Ihres individuell auf Sie zugeschnittenen Projekts.

HIER KLICKEN FÜR IHR AR- / VR-PROJEKT

Bildrechte Titelbild: © insta_photos – Adobe Stock