Vom Storytelling zum Storyliving

Ein guter Film vermag es, Charaktere zum Leben zu erwecken. Gute Filme lassen uns vergessen, dass wir lediglich eine Leinwand oder einen Bildschirm anstarren und ermöglichen es uns, in eine ganz neue Realität einzutauchen.

Doch selbst, wenn wir noch so laut den Protagonisten eines Horror-Films anschreien, er solle doch nicht alleine in den gespenstischen Wald gehen, wissen wir doch ganz genau, dass dies nichts nutzen wird. Denn eines ist in jedem Film gewiss: Der Charakter wird seiner vorbestimmten Wege gehen, egal, wie sehr wir es auch zu verhindern versuchen.

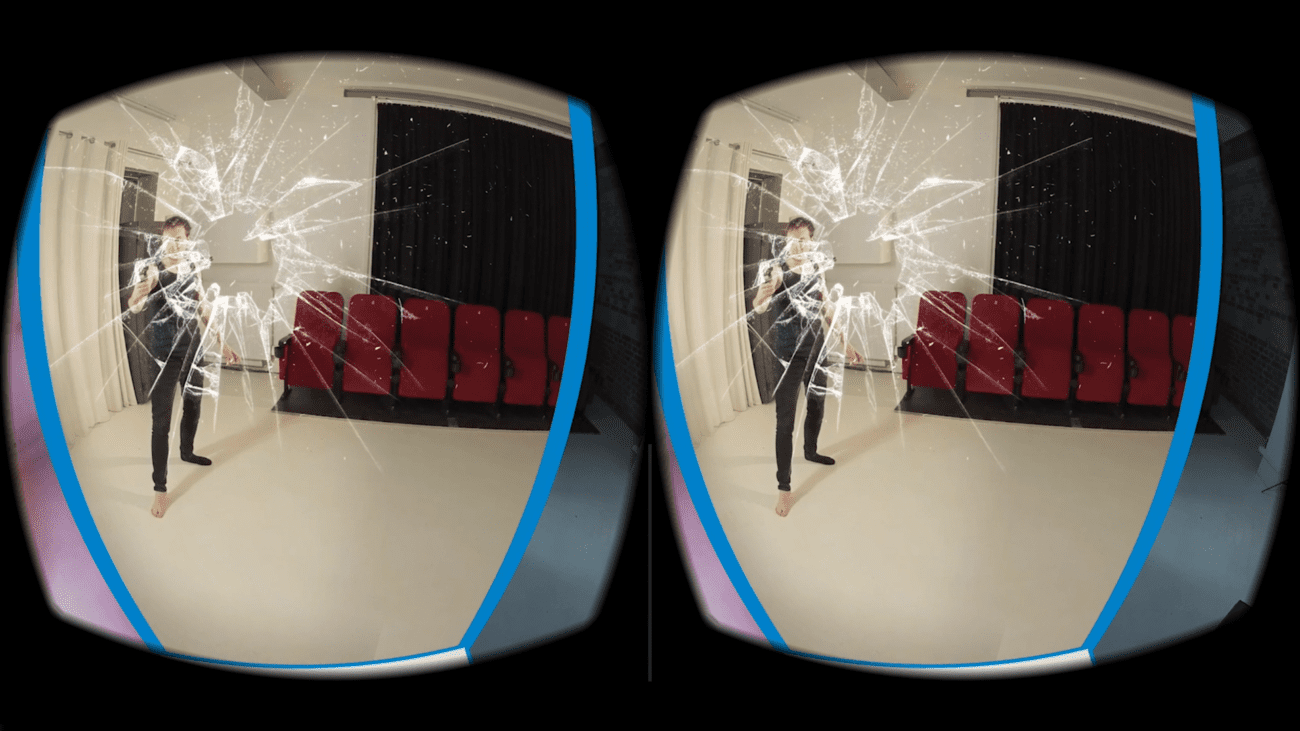

360°-Filme ermöglichen es uns, das Präsenz-Gefühl noch weiter zu steigern. Mehr noch als es in klassischen Filmen möglich wäre, fühlen sich Zuschauer, als wären sie Teil der Welt, die dem Film zugrunde liegt. Dennoch: Auch 360°-Filme stehen für ein rein passives Erleben. Zwar können Zuschauer frei entscheiden, in welche Richtung sie blicken, doch ein aktives Eingreifen in die Handlung wird ihnen auch in diesem Medium nicht ermöglicht.

Wie aber wäre es, wenn diese Faustregel ausgehebelt werden könnte? Wenn Zuschauer auf ganz natürliche Weise – durch Blick und Stimme – mit virtuellen Charakteren interagieren und so die Geschichte formen könnten?

Ein Beispiel:

Sie sitzen mit einigen Freunden an einem Lagerfeuer. Über Ihnen erstreckt sich der weite, klare Sternenhimmel. Der bärtige junge Mann an der Gitarre merkt sofort an Ihrem Blick, dass Ihnen der Sinn nach einem Lied steht. Es ist schon kurz nach Mitternacht, weshalb – noch ehe der Sänger den ersten Ton anstimmen kann – die schon leicht angetrunkene Frau zu Ihrer Rechten laut verkündet, ein Schauermärchen erzählen zu wollen. Doch Ihre Aufmerksamkeit gilt ganz dem Gitarristen. Gekränkt steht die Frau auf und stolpert in Richtung des nahe gelegenen Waldes. Sie rufen ihr nach. Sie bleibt stehen und dreht sich zu Ihnen um. Ein breites Grinsen ziert ihr Gesicht.

Ohne auch nur ein einziges Mal eine bewusste Entscheidung zwischen verschiedenen Handlungspfaden getroffen zu haben, haben Sie den Verlauf der Geschichte doch aktiv gelenkt. Anstatt mit den Buttons eines künstlichen Eingabegerätes mit der virtuellen Welt zu interagieren, haben Sie lediglich Blicke und Ihre Stimme benutzt – ganz so, wie Sie es auch getan hätten, wenn Sie an einem echten Lagerfeuer Platz genommen hätten. Zu keinem Zeitpunkt wurden Ihnen künstliche User-Interface-Elemente eingeblendet, die Ihre Immersion gestört hätten.

Was nach einer Zukunftsvision klingt, wird mit der brandneuen Hyperresponsive-VR-Technologie von Aspekteins Wirklichkeit.

Wie pflanzt man einen Entscheidungsbaum

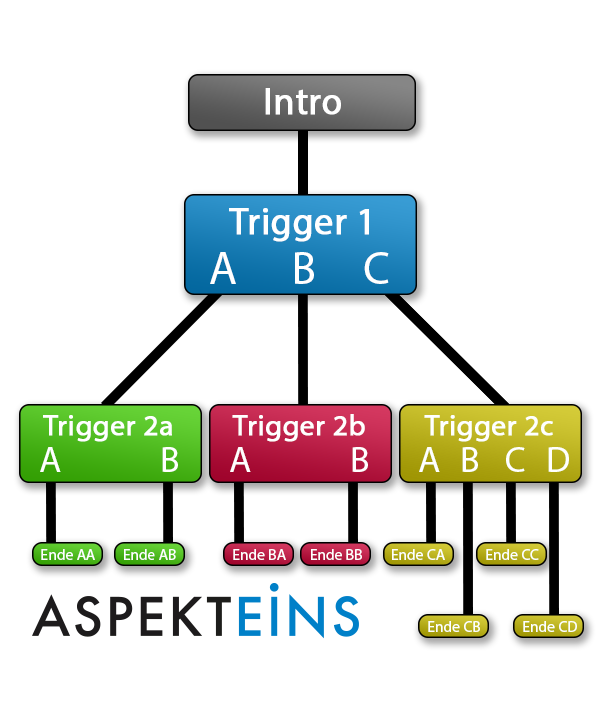

Hyperresponsive Anwendungen passen sich vollkommen dynamisch an das Verhalten des Nutzers an – ganz ohne Unterbrechungen. In zahlreichen Situationen verzweigt die Geschichte und die Applikation entscheidet selbstständig, welcher Pfad besser zum Verhalten des Nutzers passt. Um jeden Entscheidungspfad darstellen zu können, lässt sich die Anwendung also vereinfacht mit einem Entscheidungsbaum visualisieren. Jede Abzweigung entspricht dabei einem Trigger oder einer Kombination von Triggern, die durch verschiedene Sensordaten des VR-Headsets ausgelöst werden können. Jeder Trigger kann dabei in zwei oder mehr Handlungspfade abzweigen. Die folgende Liste zeigt eine Auswahl der Trigger, die in einer HRVR-App eingesetzt und miteinander kombiniert werden können:

- 1. Motion Trigger / Motion-Analytic-Trigger

- 2. Sound Trigger / Sound-Analytic-Trigger

- 3. Voice Trigger

- 4. Gaze Trigger / Gaze-Analytic-Trigger

- 5. Time Trigger

- 6. Location Trigger

- 7. Weather Trigger

- 8. Data Trigger (lokal und nicht-lokal)

- 9. Contextual Trigger

Das Gyroskop des VR-Headsets erlaubt es, die Ausrichtung des Headsets exakt zu definieren und damit auch Kopfbewegungen in jede Richtung zu ermitteln.

So ist es beispielsweise denkbar, dass ein Motion Trigger aktiviert wird, wenn der Nutzer in einem bestimmten Moment in eine festgelegte Richtung blickt. Genauso kann ein derartiger Trigger die Blickrichtung über einen längeren Zeitraum beobachten: Er wird in diesem Falle sofort aktiviert, sobald der Nutzer die Bedingung erfüllt – wenn er beispielsweise seinen Blick abwendet oder sich zu schnell bewegt.

Als Motion-Analytic-Trigger kann der Bewegungssensor genutzt werden, um die Aufmerksamkeit des Zuschauers zu messen: Innerhalb eines bestimmten Zeitintervalls misst die Applikation, wie lange der Nutzer in eine bestimmte Richtung blickt und ermittelt damit, wie viel Aufmerksamkeit der Anwender welchen Teilen des 360°-Videos widmet.

Durch den Einsatz von Sound Triggern kann die hyperresponsive Anwendung auf Geräusche des Anwenders reagieren. Ruft er beispielsweise einem Charakter zu, so könnte dieser aufblicken. Gemessen wird dabei der Lautstärkepegel, den das Mikrofon des VR-Headsets erkennt. Überschreitet der Pegel einen definierten Wert, so wird der Trigger aktiv.

Auch der Sound-Trigger kann als Analytic-Trigger verwendet werden, über einen längeren Zeitraum „horchen“ und ermitteln, ob der Nutzer innerhalb des Zeitraums besonders leise oder laut gewesen ist.

Während Sound Trigger lediglich eine Lautstärke ermitteln, reagieren Voice Trigger auf bestimmte Worte und Sätze. Durch einen Speech-to-Text-Wandler wird jedes gesprochene Wort in Echtzeit digitalisiert und mit einer für diesen Zweck angelegten Datenbank abgeglichen – dies ist dasselbe Prinzip, das auch Sprachassistenten wie Siri und Alexa nutzen. Erkennt die Anwendung ein in dieser Datenbank befindliches Wort oder eines der darin definierten Synonyme, so wird der Trigger aktiviert und löst entweder sofort oder zum nächstmöglichen Zeitpunkt den entsprechenden Handlungspfad aus.

Der Gaze-Trigger ist eine erweiterte Form des Motion Triggers. Headsets mit Eye-Tracking, beispielsweise die Vive Pro Eye, können genau ermitteln, wohin Anwender blicken. Charaktere können durch den Einsatz von Gaze Triggern also beispielsweise direkt darauf reagieren, ob Nutzer Ihnen in die Augen blicken oder in die Ferne starren. Im Unterschied zu Motion Triggern wird hier nicht die Kopfbewegung, sondern die Bewegung der Pupillen analysiert.

Gaze-Analytic-Trigger erlauben es, die Aufmerksamkeit des Nutzers noch diffiziler zu ermitteln.

Time Trigger sind nicht direkt vom Nutzer beeinflussbar, sondern greifen auf die aktuelle Uhrzeit und das aktuelle Datum zurück. Mithilfe von Time Triggern können beispielsweise Anwendungen gestaltet werden, die Nachts anders verlaufen als am Tag oder die Nutzer an Feiertagen festlich empfangen.

Ähnlich wie Time Trigger sind auch Location Trigger nur indirekt vom Nutzer beeinflussbar. Durch das Auslesen von Standortdaten können Anwendungen gezielt auf Nutzer eingehen. Befindet sich beispielsweise eine Filiale Ihres Unternehmens in der Nähe des Benutzers, so kann die Applikation diesen gezielt darauf hinweisen.

Durch die Verknüpfung des Standorts mit Live-Daten aus Wetterdatenbanken kann auch das derzeitige Wetter, genau dort, wo sich der Nutzer befindet, ermittelt werden. Das Wetter kann so in die virtuelle Welt übertragen werden und sogar die Handlung beeinflussen.

Data Trigger gibt es sowohl in lokaler wie auch in nicht-lokaler Ausführung. Lokale Data Trigger analysieren die Merkmale und Sensoren des VR-Ökosystems, auf dem sie ausgeführt werden. So kann eine für Smartphone-Systeme optimierte App zum Beispiel darauf reagieren, dass sich der Akku des Handys dem Ende entgegen neigt. Lokale Daten können auch durch die Anwendung selbst angelegt werden: Auf diese Weise kann beispielsweise ermittelt werden, wie sich Nutzer in vorherigen Durchläufen verhalten haben oder wie oft die Anwendung schon gestartet wurde.

Nicht-lokale Data Trigger greifen dagegen auf Internetdatenbanken zu und können damit dynamisch auf Live-Daten wie Aktienkurse, Klickzahlen oder Tweets von US-Präsidenten reagieren.

Contextual Trigger entsprechen den klassischen Hotspots in herkömmlichen 360°-Anwendungen und eignen sich daher besonders für die Verwendung von Menüs und abstrakten Bedienelementen. Dieser Trigger wird aktiviert, sobald Zuschauer für einige Sekunden auf einen Hotspot oder auf ein zuvor definiertes Objekt blicken. Zur intuitiven Bedienung kann ein Fadenkreuz eingeblendet werden. Blickt der Nutzer auf einen Hotspot, so erscheint ein Timer um das Fadenkreuz, nach dessen Ablauf der Trigger aktiviert wird.

Damit dieses Fadenkreuz die immersive Erfahrung der hyperresponsiven Anwendung nicht stört, erscheint dieses nur, wenn Nutzer in die Nähe eines Hotspots mit Contextual Trigger blicken.

Die Welt der Hyperresponsiveness steht Ihnen offen – Mit der HRVR-Plattform

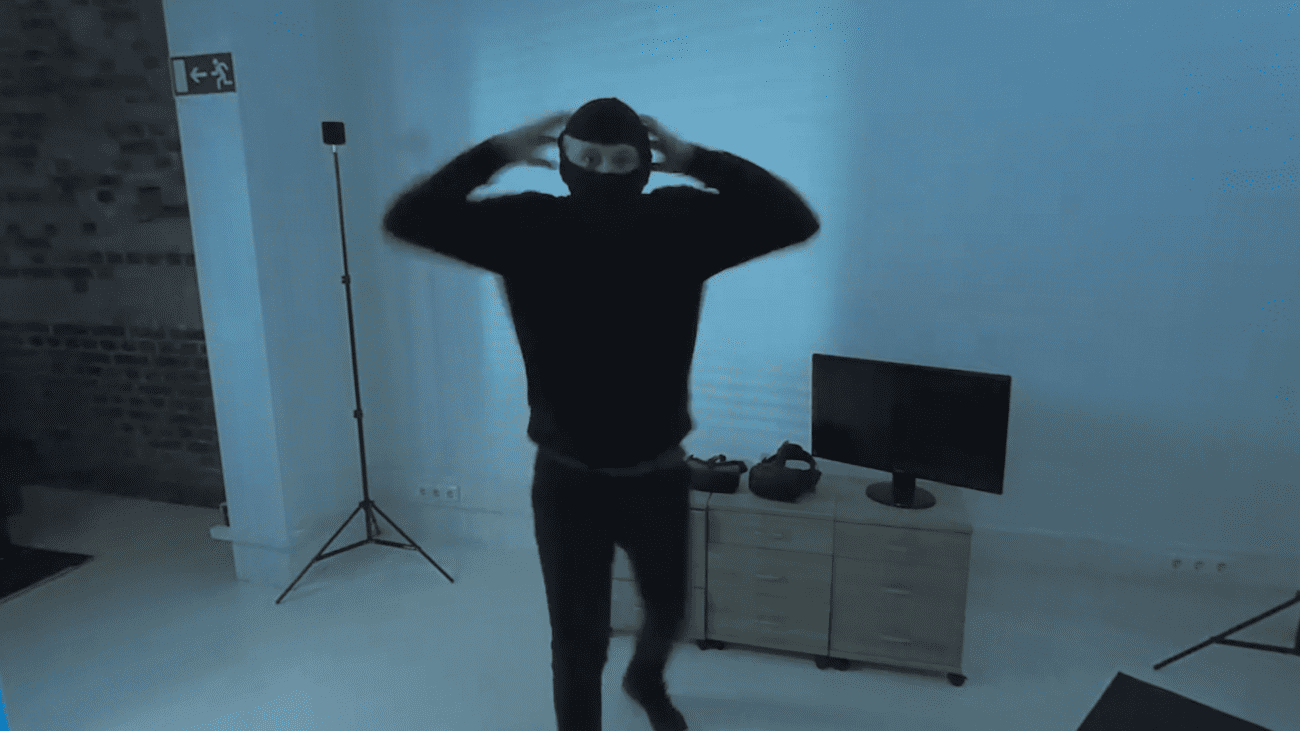

All das ist natürlich nicht nur blanke Theorie: In den letzten Monaten haben wir eifrig daran gearbeitet, den Traum der Hyperresponsiveness Realität werden zu lassen. Das Ergebnis unserer Arbeit ist ein Prototyp, in dem Nutzer einen Einbruch verhindern, einem tanzenden Hasen den Schreck seines Lebens versetzen und eine Gefahrensituation deeskalieren können. Zur Seite steht dem Anwender dabei ein Moderator, der ihm dynamisch passende Hinweise gibt und selbstständig feststellt, ob er vom Nutzer aufmerksam angesehen wird.

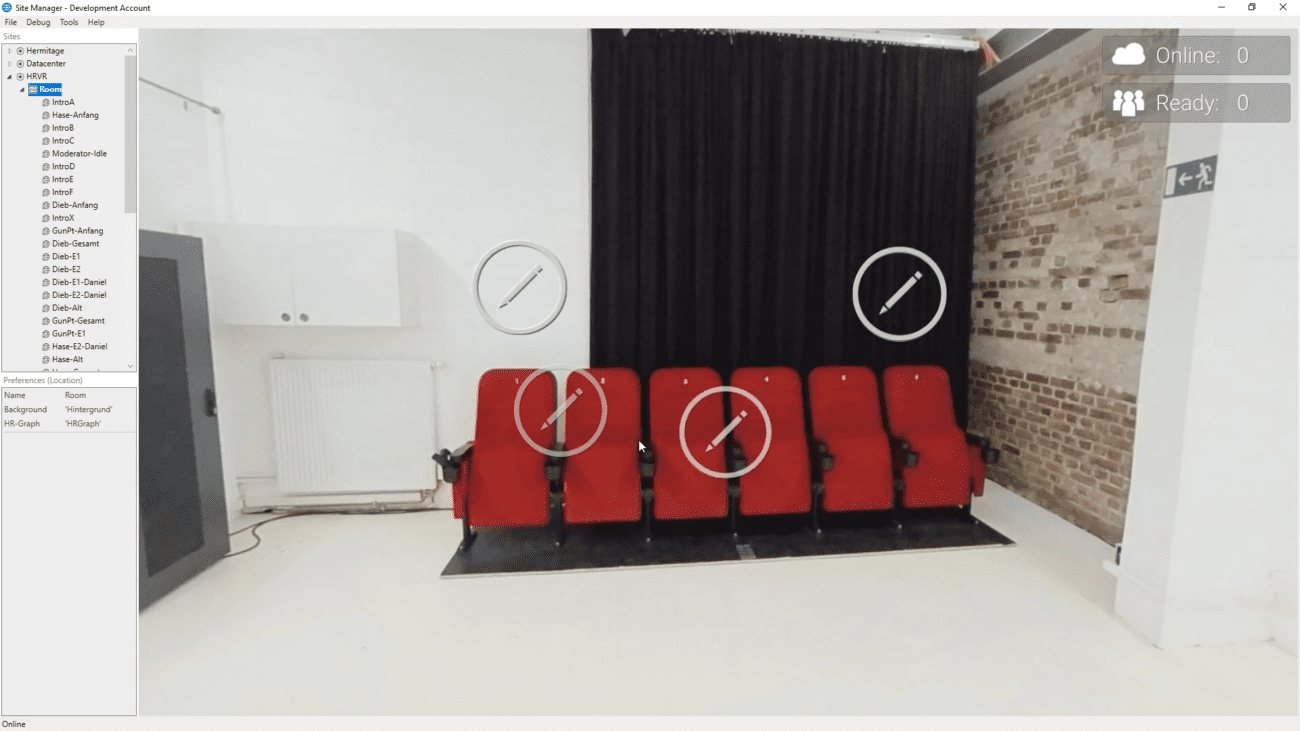

Um den Überblick auch über stark verzweigte Entscheidungsbäume und eine Vielzahl von Videoschnippseln zu behalten, entwickelte Aspekteins eine eigene Plattform für HRVR-Anwendungen. Sämtliche Assets und Trigger können in dieser frei gesetzt und angepasst werden – ganz ohne in die Tiefen des Codes eingreifen zu müssen. Dank intuitiver Bedienung können somit Feedbackloops kurz gehalten und auch komplexe Anwendungen schnell und effizient gestaltet werden. Die HRVR-Anwendung bietet eine Vielzahl an Features und wird stetig weiterentwickelt:

- Echtzeit-Preview für das Arbeiten am Entscheidungsbaum

- Zahlreiche Möglichkeiten zur Anpassung sämtlicher Trigger

- Umfangreiche Auswertungsmöglichkeiten des Nutzerverhaltens

- Speicheroptimierung durch Aufspalten der 360°-Videos in redundante und nicht-redundante Bildinhalte

- 3D-Sound durch Object-based Audio

- Präsentations-Modus: Master-System kann gleichzeitig mehrere VR-Headsets ansteuern und Marker setzen

- Möglichkeit zum Einbinden traditioneller Inhalte (klassische Videos oder Bilder auf virtueller Leinwand, Texttafeln, Audios, …) und zur Navigation zwischen verschiedenen virtuellen Räumen

- Sämtliche Apps werden bei einem Update automatisch aktualisiert

- Individuelles Branding

- Unterstützt alle gängigen VR-Headsets sowie die Wiedergabe auf Smartphones

Begleiten Sie uns auf dem Weg hin zur nächsten Evolutionsstufe interaktiver VR-Erfahrungen. Wir freuen uns darauf, bei einem gemeinsamen Termin die Möglichkeiten der HRVR-Technologie für Ihr Unternehmen zu erörtern und Ihnen unseren Prototyp persönlich vorzustellen. Sie produzieren selbst 360°-Inhalte, haben Interesse daran, auch Ihren Kunden HRVR-Erfahrungen anbieten zu können und möchten hierfür unsere HRVR-Plattform lizensieren? Auch in diesem Fall gilt: Zögern Sie nicht, uns zu kontaktieren. Einige Tipps und Tricks für das Konzipieren von nicht-linearen Geschichten finden Sie zudem auch in unserem Artikel „Wie plant man eine nicht-lineare Geschichte?“.